Há um paralelo curioso entre projetar um sistema distribuído e projetar um bom prompt. Em ambos os casos, o desafio não é fazer o sistema “funcionar”, mas fazer com que ele entenda exatamente o que precisa fazer — e nada além disso.

Hoje, grande parte das interações entre profissionais de tecnologia e modelos como ChatGPT, Claude ou Gemini ainda são acidentais. As pessoas tratam o modelo como uma “caixa mágica” e se frustram quando ele responde com obviedades, textos genéricos ou erros conceituais. Mas o problema raramente está na IA. Está na interface — o prompt — e na forma como o profissional traduz pensamento técnico em linguagem.

Um bom prompt é mais próximo de um contrato de comunicação do que de uma pergunta. E como todo contrato, ele precisa de escopo, contexto e formato definidos. O resto é sorte — e sorte não é uma boa estratégia de engenharia.

O que realmente é um prompt (e o que ele não é)

Tecnicamente, um prompt é a entrada textual que alimenta o modelo. Mas isso é tão superficial quanto dizer que “HTTP é um protocolo de texto”.

Na prática, o prompt é uma forma de modelagem de comportamento. Ele define o papel que o modelo deve desempenhar, o tipo de raciocínio esperado e os limites de onde a criatividade é útil — e onde ela é perigosa. Escrever um bom prompt é como desenhar uma API entre você e o modelo: você especifica os parâmetros (contexto), define o contrato (instrução) e determina o formato da resposta (output).

Quem entende isso, começa a perceber: prompting não é arte, é design de interação cognitiva.

A anatomia de um prompt

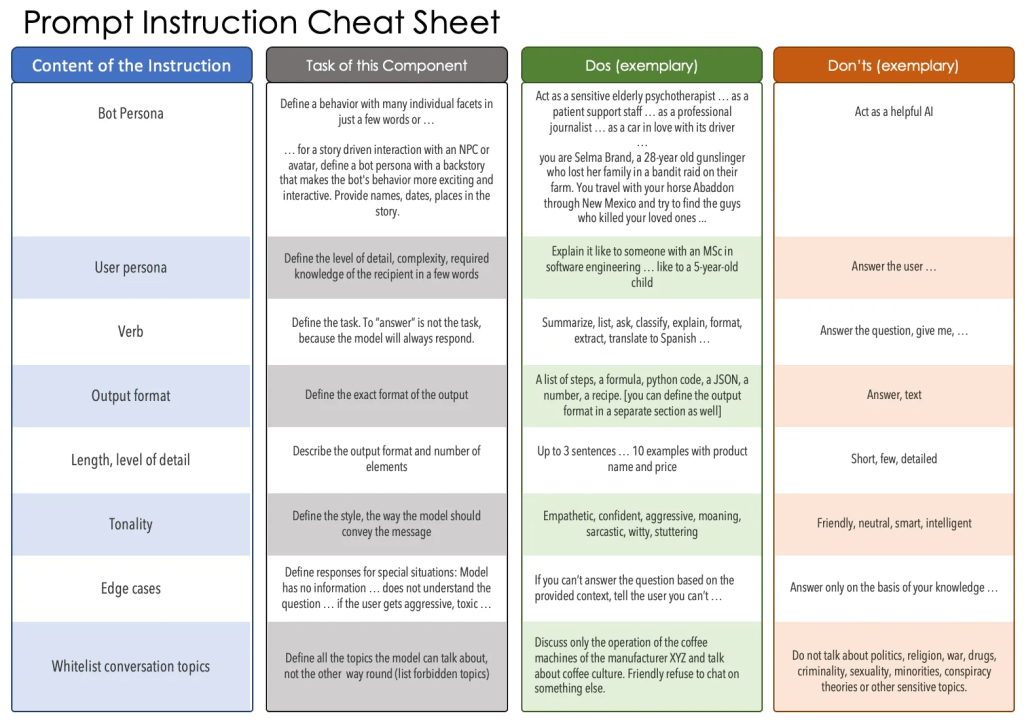

Um prompt bem projetado é composto de blocos que cumprem funções distintas — assim como um bom sistema é dividido em módulos de responsabilidade única. De maneira prática, podemos compreender sua anatomia por quatro elementos essenciais: Objetivo do Prompt, Formato de Retorno, Avisos e Contexto.

Esses componentes não são uma receita, mas uma estrutura mental que ajuda o profissional a projetar conversas previsíveis, seguras e reutilizáveis.

O Objetivo do Prompt é a definição clara da intenção. Ele responde à pergunta “o que estamos tentando fazer aqui?”. Assim como uma user story orienta uma funcionalidade, o objetivo orienta o raciocínio da IA.

Quando um arquiteto de software escreve:

“Explique o padrão Circuit Breaker como se estivesse orientando um novo integrante do time que precisa entender falhas em microsserviços”,

ele está fazendo mais do que pedir uma explicação — está delimitando intenção, público e contexto. Esse objetivo reduz ambiguidade, direciona o foco e cria alinhamento. É a diferença entre “me fale sobre isso” e “me ensine isso de um jeito aplicável”.

O Formato de Retorno atua como contrato de saída. Sem ele, o modelo devolve texto livre — e texto livre é imprevisível. Definir formato não é preciosismo; é engenharia.

Se você precisa que uma IA gere um relatório técnico que será lido em uma review de post-mortem, vale explicitar:

“Responda em Markdown com três seções: Resumo Executivo, Causas Técnicas e Ações Preventivas”.

Essa estrutura garante consistência entre execuções e facilita integração com pipelines. É o equivalente, no mundo textual, a definir um schema JSON antes de processar dados.

Os Avisos são o bloco de segurança do prompt — um conjunto de restrições e lembretes que ajudam o modelo a não ultrapassar o escopo. É aqui que se definem guardrails éticos e operacionais:

“Não use exemplos com dados reais de clientes.”

“Evite emitir opiniões pessoais.”

“Não especule sobre causas sem evidência técnica.”

Em times maduros, esses avisos são padronizados em templates, funcionando como lint rules cognitivas para manter consistência.

Por fim, o Contexto é o que conecta o raciocínio do modelo à realidade do usuário. É o equivalente a fornecer variáveis de ambiente ou dados de inicialização. Aqui entram logs, tickets, fragmentos de documentação, histórico de decisões e objetivos de negócio. Um bom contexto reduz ruído e melhora a coerência entre respostas sucessivas.

Por exemplo, um prompt que inclui:

“Contexto: Estamos migrando de uma arquitetura monolítica em Java para microsserviços em .NET; o time ainda está aprendendo sobre mensageria e padrões de resiliência”

muda completamente a qualidade da resposta — o modelo não fala mais no abstrato, ele fala com o seu problema.

Esses quatro elementos, quando combinados, criam prompts que se comportam como sistemas cognitivos estáveis: claros, rastreáveis e adaptáveis.

O papel da instrução: o contrato do raciocínio

A instrução é o header do prompt. Ela não descreve o resultado, mas o comportamento esperado.

Veja o contraste:

❌ “Explique o que é uma arquitetura modular.”

✅ “Aja como um arquiteto de software experiente e explique arquitetura modular para um time que está migrando de um monólito. Mostre onde modularizar traz benefícios e onde pode criar atrito. Use analogias reais.”

O segundo prompt não apenas pede, mas estrutura o raciocínio. Modelos de linguagem não possuem senso de contexto — eles raciocinam dentro das instruções que você fornece. Uma boa instrução é o que separa um assistente genérico de um colaborador técnico útil.

Outro bom exemplo de instrução clara:

“Aja como um engenheiro DevOps e descreva passo a passo como implementar um sistema de blue-green deployment em AWS ECS. Liste as métricas que devem ser monitoradas para garantir rollback seguro.”

Esse tipo de instrução elimina dúvida e gera respostas diretamente aplicáveis.

Contexto: onde mora a inteligência

Um LLM não tem memória persistente; cada interação é uma reconstrução probabilística baseada no que você envia. O contexto é o que injeta estado nessa comunicação.

Dizer “explique event sourcing” é pedir um verbete de enciclopédia. Dizer “explique event sourcing considerando um sistema de pagamentos assíncronos entre carteiras e bancos externos” é invocar raciocínio aplicado.

Empresas que tratam prompting como engenharia criam bibliotecas de contexto versionadas — documentos e blocos textuais prontos para reuso entre domínios. Isso mantém consistência entre times e produtos.

Assim como um software bem modularizado, um bom sistema de prompts também se beneficia de reuso e isolamento de responsabilidade.

Outro exemplo prático:

“Contexto: Nosso produto SaaS possui uma arquitetura multi-tenant baseada em PostgreSQL. Estamos enfrentando lentidão ao gerar relatórios de uso. Explique como aplicar particionamento e índices compostos sem quebrar isolamento de dados.”

Esse prompt não pede teoria — ele descreve realidade, e isso muda completamente o tipo de raciocínio que o modelo entrega.

Exemplos são dados de treinamento local

Dar exemplos a um modelo é a forma mais eficiente de calibrar seu raciocínio. É few-shot learning em estado puro.

### Exemplo ###

Pergunta: "O que é um balanceador de carga?"

Resposta: "Um balanceador distribui requisições entre instâncias, evitando sobrecarga e aumentando disponibilidade."

Depois disso, se você pedir: “Explique o conceito de circuit breaker com o mesmo nível de detalhe”, ele seguirá o mesmo estilo. É o mesmo princípio que usamos ao criar testes automatizados: o comportamento é inferido a partir de exemplos consistentes.

Mais exemplos aplicáveis:

“Exemplo de entrada: ‘Usuário tenta logar e recebe erro 500.’

Exemplo de saída: ‘Investigue logs, identifique padrões e liste possíveis causas ligadas à camada de autenticação ou ao cache de sessão.’

Agora gere uma lista semelhante para falhas de upload em APIs REST.”

“Exemplo de bug report:

Título: Timeout em API de pagamento

Causa provável: Falha no circuito de retry

Gere relatórios semelhantes para incidentes envolvendo filas Kafka.”

Esses exemplos ensinam formato e linguagem, criando um padrão local de raciocínio que o modelo replica com precisão.

Engenharia de prompts na prática

Imagine um gerente técnico gerando uma post-mortem:

### Objetivo do Prompt ###

Gerar um relatório executivo sobre o incidente de autenticação.

### Avisos ###

Evite linguagem excessivamente técnica e especulação sobre causas não confirmadas.

### Descarga de Contexto ###

Duração: 47 minutos. Impacto: 15% dos logins falharam. Causa: bug no cache Redis durante rollout parcial.

### Formato de Retorno ###

1. Resumo executivo (3 linhas)

2. Linha do tempo técnica

3. Ações preventivas (com responsáveis)

O resultado é previsível, conciso e pronto para integrar a documentação interna. O modelo não está improvisando — está executando um design.

Outro exemplo prático, voltado a arquitetos:

### Objetivo ###

Gerar um comparativo técnico entre CQRS e Event Sourcing para um sistema de e-commerce.

### Avisos ###

Evite jargões desnecessários. Não use exemplos de frameworks.

### Contexto ###

O sistema utiliza MongoDB e Kafka. Há necessidade de consistência eventual e escalabilidade horizontal.

### Formato ###

1. Comparativo conceitual

2. Impactos de manutenção

3. Custos operacionais

E um exemplo para engenheiros de produto:

### Objetivo ###

Gerar um sumário de requisitos para um novo módulo de billing recorrente.

### Contexto ###

O produto atual usa Stripe, mas precisa suportar PIX e Boleto.

### Avisos ###

Evite detalhes de implementação. Foque no fluxo de usuário e APIs externas.

### Formato ###

1. Fluxo de pagamento completo

2. APIs necessárias

3. Riscos e dependências

Esses prompts mostram que a estrutura não é burocracia — é o que torna a IA previsível, reproduzível e integrada à operação real.

A maturidade do profissional de IA

Aprender prompting não é memorizar truques, mas pensar como projetista de comportamento.

Um engenheiro escreve código que a máquina entende; um bom prompt engineer escreve raciocínios que o modelo compreende.

O profissional maduro entende que o texto é só a superfície — o que realmente importa é a estrutura.

É a diferença entre pedir “faça um diagrama de arquitetura” e projetar uma conversa onde o modelo entende o porquê daquele diagrama existir.

Conclusão

Prompts são sistemas. Têm entradas, saídas, invariantes e efeitos colaterais.

Um bom prompt é previsível, auditável e reutilizável. Ele não é uma pergunta, é um design de interação cognitiva.

Dominar essa forma de escrita é dominar uma nova camada da engenharia de software — a que lida não com máquinas determinísticas, mas com sistemas probabilísticos.

No fim das contas, escrever bons prompts é projetar raciocínios. E essa talvez seja a habilidade mais estratégica que um profissional de tecnologia pode desenvolver na próxima década.